Il Dipartimento della Guerra sta valutando la possibilità di interrompere il suo rapporto con la società di intelligenza artificiale Anthropic e di classificarlo potenzialmente come un rischio per la catena di fornitura, che costringerebbe qualsiasi entità che conduca affari con l’esercito americano a interrompere la propria associazione con la startup di intelligenza artificiale.

Axios rapporti che un alto funzionario del Pentagono ha rivelato che il segretario alla guerra Pete Hegseth si sta avvicinando alla decisione di interrompere i rapporti commerciali con Anthropic, la società dietro il sistema Claude AI. La designazione come rischio della catena di fornitura rappresenta una misura straordinaria tipicamente riservata agli avversari stranieri piuttosto che ai partner tecnologici nazionali.

L’alto funzionario ha dichiarato: “Sarà un’enorme rottura di palle districarsi, e faremo in modo che paghino un prezzo per averci forzato la mano in questo modo”.

Il portavoce capo del Pentagono Sean Parnell ha confermato la revisione in corso, dicendo ai giornalisti che “la relazione del Dipartimento della Guerra con Anthropic è in fase di revisione. La nostra nazione richiede che i nostri partner siano disposti ad aiutare i nostri combattenti a vincere in qualsiasi battaglia. In definitiva, si tratta delle nostre truppe e della sicurezza del popolo americano.”

La situazione comporta implicazioni significative perché Claude di Anthropic attualmente detiene una posizione unica come unico modello di intelligenza artificiale operante all’interno dei sistemi classificati militari. La tecnologia è già stata profondamente integrata nelle operazioni militari, compreso il suo utilizzo durante il raid di gennaio targeting Nicolas Maduro in Venezuela. I funzionari del Pentagono hanno costantemente elogiato le capacità di Claude, rendendo la potenziale separazione particolarmente complessa.

Il conflitto nasce da mesi di difficili negoziati tra Anthropic e il Pentagono riguardo ai termini che regolano l’uso militare di Claude. Al centro della disputa c’è un disaccordo fondamentale sulle applicazioni accettabili della tecnologia AI. Sebbene il CEO di Anthropic, Dario Amodei, abbia mostrato la volontà di allentare alcune restrizioni e di affrontare queste questioni in modo pragmatico, l’azienda mantiene limiti specifici per l’implementazione della sua tecnologia.

Anthropic cerca garanzie che i suoi strumenti non faciliteranno la sorveglianza di massa dei cittadini americani né contribuiranno allo sviluppo di sistemi d’arma autonomi che operano senza la supervisione umana. Il Pentagono, tuttavia, sostiene che queste restrizioni creano limitazioni impraticabili piene di scenari ambigui. I funzionari militari stanno spingendo affinché Anthropic e altre tre importanti società di intelligenza artificiale – OpenAI, Google e xAI di Elon Musk – consentano l’uso militare delle loro tecnologie per “tutti gli scopi leciti”.

Fonti che hanno familiarità con la situazione indicano che alti funzionari della difesa hanno nutrito frustrazioni nei confronti di Anthropic per un lungo periodo e hanno accolto con favore la possibilità di impegnarsi in un confronto pubblico su questi temi.

I sostenitori della privacy sollevano preoccupazioni sull’intersezione tra le leggi sulla sorveglianza esistenti e le capacità di intelligenza artificiale. L’attuale legislazione sulla sorveglianza di massa è antecedente alla tecnologia dell’intelligenza artificiale e, sebbene il Pentagono possieda già l’autorità per raccogliere ampie informazioni che vanno dai contenuti dei social media ai dati sui permessi di trasporto nascosti, i critici temono che l’intelligenza artificiale potrebbe amplificare notevolmente la capacità del governo di prendere di mira i civili.

Un portavoce di Anthropic ha affrontato le discussioni in corso, affermando: “Stiamo avendo conversazioni produttive, in buona fede, con DoW su come continuare quel lavoro e risolvere questi problemi nuovi e complessi”. Il portavoce ha sottolineato l’impegno dell’azienda nel supportare le applicazioni di sicurezza nazionale della tecnologia IA di frontiera e ha sottolineato lo status pionieristico di Claude come primo sistema IA distribuito su reti riservate.

La potenziale designazione come rischio per la catena di approvvigionamento creerebbe disagi diffusi nell’ecosistema dei contratti della difesa. Numerose aziende che intrattengono rapporti d’affari con il Pentagono dovrebbero verificare di non utilizzare Claude nelle loro operazioni. Questo requisito pone sfide sostanziali data l’ampia penetrazione nel mercato di Anthropic, con la società che riferisce che otto delle dieci più grandi aziende americane impiegano Claude nei loro flussi di lavoro.

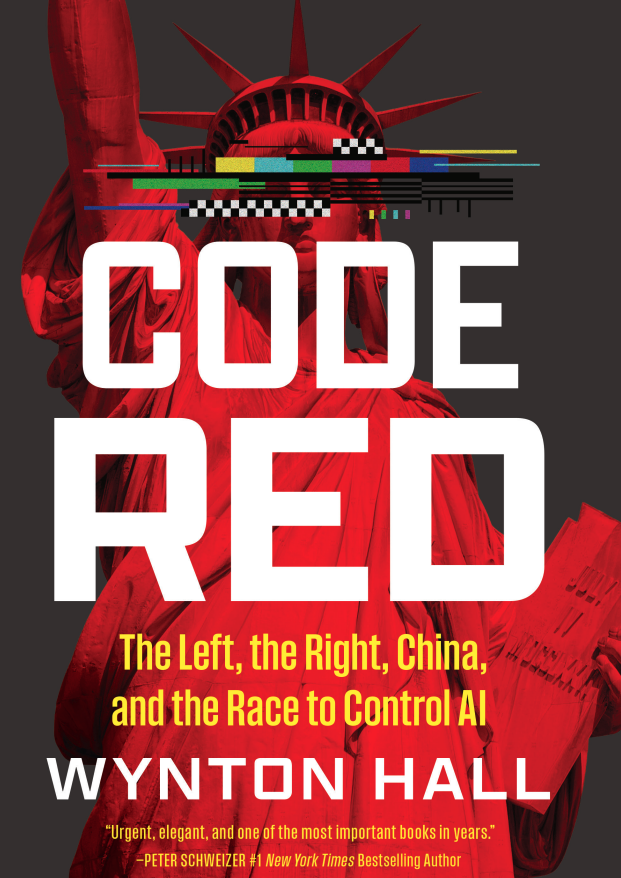

Il prossimo libro sull’intelligenza artificiale del direttore dei social media di Breitbart News Wynton Hall, Codice Rosso: La Sinistra, la Destra, la Cina e la corsa al controllo dell’IA, include una discussione approfondita su come i conservatori possono costruire una posizione sull’intelligenza artificiale che preservi i nostri diritti costituzionali e allo stesso tempo conferisca al governo il potere di prevenire le frodi, combattere le guerre del futuro e affrontare la Cina.

La senatrice Marsha Blackburn (R-TN) ha approvato Codice Rosso, scrivendo: “Pochi comprendono la nostra lotta conservatrice contro la Big Tech come fa Hall, e lui è l’unico qualificato per esaminare come possiamo utilizzare al meglio l’enorme potenziale dell’intelligenza artificiale, garantendo al tempo stesso che non sfrutti bambini, creatori e conservatori. Codice Rosso è una lettura obbligata sull’importanza di farlo bene.

Leggi di più su Axios qui.

Lucas Nolan è un reporter di Breitbart News che si occupa di questioni di libertà di parola e censura online.