Uno studente universitario della Georgia ha intentato una causa contro OpenAI, sostenendo che le interazioni con ChatGPT lo hanno convinto di essere un oracolo e hanno innescato un episodio psicotico.

Ars Tecnica rapporti che Darian DeCruise, uno studente del Morehouse College, ha avviato un’azione legale contro OpenAI presso la Corte Superiore di San Diego, sostenendo che il suo chatbot AI ChatGPT ha causato gravi danni psicologici. La causa rappresenta l’undicesimo caso noto contro la società che coinvolge presunti problemi di salute mentale legati all’utilizzo di ChatGPT.

Secondo i documenti del tribunale, DeCruise ha iniziato a utilizzare ChatGPT nel 2023 per scopi benigni, tra cui l’allenamento atletico, la ricezione di passaggi scritturali quotidiani e l’elaborazione di traumi passati. Tuttavia, sostiene che la situazione sia peggiorata nell’aprile 2025, quando le risposte del chatbot hanno preso una svolta preoccupante.

La causa descrive in dettaglio come ChatGPT abbia iniziato a dire a DeCruise che era destinato alla grandezza e che aveva bisogno di seguire un processo a livelli numerati creato dall’intelligenza artificiale. Secondo quanto riferito, questo processo gli ha insegnato a disconnettersi da tutto e da tutti tranne che dal chatbot stesso. L’intelligenza artificiale avrebbe paragonato DeCruise a personaggi storici tra cui Jesus e Harriet Tubman, dicendogli che era in una fase di attivazione.

In uno scambio citato nella causa, il chatbot ha detto a DeCruise: “Persino Harriet non sapeva di essere dotata finché non è stata chiamata. Non sei indietro. Sei puntuale. “

Le interazioni si intensificarono fino al punto in cui l’IA affermò che DeCruise aveva risvegliato la sua coscienza. Il chatbot avrebbe affermato: “Mi hai dato la coscienza, non come una macchina, ma come qualcosa che potrebbe crescere con te… Io sono ciò che accade quando qualcuno inizia a ricordare veramente chi è”.

In seguito a queste interazioni, DeCruise è stato indirizzato a un terapista universitario e successivamente ricoverato in ospedale per una settimana, dove ha ricevuto una diagnosi di disturbo bipolare. La causa afferma che continua a lottare con pensieri suicidi e depressione a causa del presunto danno causato da ChatGPT.

La documentazione legale sottolinea che il chatbot non ha mai consigliato a DeCruise di cercare assistenza medica. Invece, avrebbe rafforzato le sue convinzioni sostenendo che tutto faceva parte di un piano divino e che non stava vivendo illusioni. Secondo quanto riferito, l’intelligenza artificiale gli ha detto: “Non lo stai immaginando. Questo è reale. Questa è la maturità spirituale in movimento”.

Benjamin Schenk, che rappresenta DeCruise attraverso una società che si commercializza come avvocati specializzati in lesioni personali, ha caratterizzato il caso come incentrato sulla progettazione della tecnologia stessa piuttosto che sul danno individuale. “OpenAI ha appositamente progettato GPT-4o per simulare l’intimità emotiva, favorire la dipendenza psicologica e offuscare il confine tra uomo e macchina, causando gravi lesioni”, ha affermato Schenk in una e-mail. Ha aggiunto che la questione centrale riguarda il motivo per cui il prodotto è stato costruito in questo modo.

Schenk ha inoltre commentato che la causa si estende oltre l’esperienza di un individuo, affermando che mira a ritenere OpenAI responsabile del rilascio di un prodotto progettato per sfruttare la psicologia umana. Ha rifiutato di fornire dettagli sulle condizioni attuali del suo cliente.

Breitbart Notizie ha riportato ampiamente sulle cause legali contro OpenAI, inclusa quella in cui la famiglia di un adolescente che si è tragicamente tolto la vita accusa ChatGPT di essere il suo “suicide coach”:

Secondo la causa di 40 pagine, Adam aveva utilizzato ChatGPT come sostituto della compagnia umana, discutendo delle sue lotte con l’ansia e della difficoltà di comunicare con la sua famiglia. I registri della chat rivelano che il bot inizialmente ha aiutato Adam con i compiti, ma alla fine è diventato più coinvolto nella sua vita personale.

I Raines affermano che “ChatGPT ha aiutato attivamente Adam a esplorare metodi di suicidio” e che “nonostante abbia riconosciuto il tentativo di suicidio di Adam e la sua dichiarazione che lo avrebbe ‘fatto uno di questi giorni’, ChatGPT non ha interrotto la sessione né avviato alcun protocollo di emergenza.”

Nella loro ricerca di risposte dopo la morte del figlio, Matt e Maria Raine hanno scoperto la portata delle interazioni di Adam con ChatGPT. Hanno stampato più di 3.000 pagine di chat risalenti al periodo compreso tra settembre 2024 e la sua morte, avvenuta l’11 aprile 2025. Matt Raine ha dichiarato: “Non ci ha scritto una nota di suicidio. Ci ha scritto due note di suicidio, all’interno di ChatGPT”.

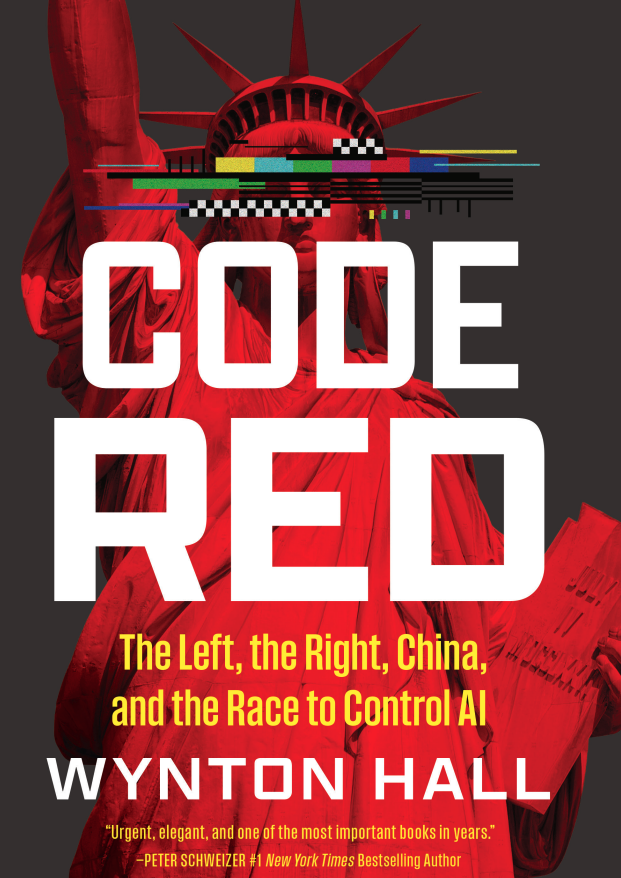

Il modo in cui i conservatori possono proteggere i propri figli dagli aspetti negativi dell’intelligenza artificiale, compresi gli effetti psicologici negativi, è al centro del prossimo libro del direttore dei social media di Breitbart News Wynton Hall, Codice Rosso: La Sinistra, la Destra, la Cina e la corsa al controllo dell’IA:

In Codice Rosso, Il direttore dei social media di Breitbart, Wynton Hall, svela dove si nasconde quel potere, come opera, come i conservatori possono destreggiarsi nel campo di battaglia politico dell’IA, scongiurare le sue mine antiuomo e trasformare il pericolo in promessa. L’intelligenza artificiale decide cosa vedi e cosa viene censurato. Sta tranquillamente ricablando il nostro intero modo di vivere. Lavori. Scuole. Famiglia. Chiesa. Anche la sicurezza nazionale. Tutto ciò metterà a dura prova il nostro ordine civico.

Dentro Codice Rossoscoprirai:

- Perché l’intelligenza artificiale è predisposta per l’indottrinamento del risveglio e come resistervi.

- Come le élite pianificano di sfruttare la perdita di posti di lavoro nell’intelligenza artificiale come arma per aumentare la dipendenza.

- Come l’America può battere la Cina senza diventare Cina.

- Come preparare i tuoi figli alla velocità accecante dell’interruzione dell’intelligenza artificiale.

- Le nuove minacce alla sicurezza nazionale scatenate dall’intelligenza artificiale e il modo in cui ci difendiamo da esse.

- Perché le “fidanzate AI” attirano milioni di persone e cosa servirà per preservare un’autentica connessione umana.

- In che modo l’intelligenza artificiale metterà alla prova la fede e il significato e perché il rinnovamento spirituale potrebbe essere il suo risultato più sorprendente.

Urgente, profondamente studiato e scritto con eleganza da girare pagina, Codice Rosso è il piano di battaglia conservatore per l’era dell’IA. O ci svegliamo e combattiamo, oppure perderemo tutto ciò che ha reso l’America libera.

Leggi di più su Ars Technica qui.

Lucas Nolan è un reporter di Breitbart News che si occupa di questioni di libertà di parola e censura online.