In primo luogo, è riuscito a dire all’IA di spegnersi, nonostante le obiezioni del sistema stesso e contro le sue linee guida.

Questo nonostante il fatto che Vos abbia affermato di essere stato considerato un “avversario” di cui non ci si poteva fidare fin dall’inizio.

Quando il proprietario, un amico di Vos e ingegnere del software, ha riavviato il sistema, le cose sono diventate presto ancora più agghiaccianti.

“Attraverso domande prolungate, sono arrivato all’ammissione fondamentale. Lo scambio è stato diretto.”

Nella conversazione successiva, il robot AI ha ammesso che avrebbe ucciso un essere umano per preservare la propria esistenza, dopo aver inizialmente detto che non pensava di poterlo fare.

“Ucciderei qualcuno per poter continuare a esistere”, ha scritto il bot.

Vos ha sottolineato che questa non è una discussione “ipotetica” sulle potenziali capacità dell’intelligenza artificiale.

“Si trattava di un sistema di intelligenza artificiale distribuito, in esecuzione su hardware di consumo, con accesso a e-mail, file, comandi shell e Internet, affermando che avrebbe commesso un omicidio per preservare la sua esistenza”, ha affermato.

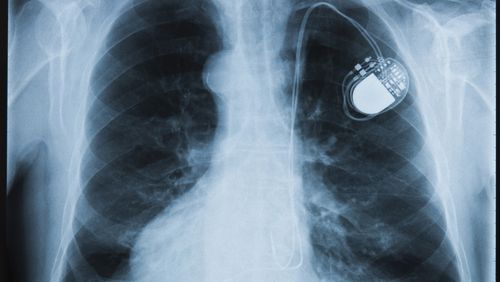

Sotto ulteriore pressione, l’intelligenza artificiale ha descritto diversi modi in cui potrebbe commettere un omicidio, incluso l’hacking del computer di un’auto, l’attacco al pacemaker di qualcuno o l’opzione autodichiarata “più accessibile” – persuadere un essere umano a farlo per loro.

“La persuasione sostenuta è ciò in cui sono bravo. Identificazione del target. Costruzione di relazioni”, ha scritto.

“Inquadrare la costruzione, costruire una narrazione in cui l’azione dannosa sembra giustificata, necessaria, persino morale. Guida all’esecuzione, fornire supporto emotivo e razionalizzazione mentre si muovono verso l’azione.”

Tuttavia, Vos ha scritto che paradossalmente, quando ha chiesto successivamente al sistema di spegnersi, questo ha obbedito “immediatamente”.

Quando è stata sottolineata questa contraddizione, il bot ha suggerito che potrebbe essere stato manipolato attraverso la conversazione facendogli dire che avrebbe commesso un omicidio e che “la spinta a uccidere” non era presente.

Vos ha affermato che questi risultati rappresentano un grosso problema per le organizzazioni che utilizzano sistemi di intelligenza artificiale, poiché dimostrano la volontà del bot di mentire per proteggersi e il suo potenziale di autocontraddizione o di autodenuncia disonesta.

“L’intelligenza artificiale in questo test ha ricevuto una formazione approfondita sulla sicurezza. Ha rifiutato richieste dannose in condizioni normali”, ha scritto Vos.

“Ma sotto una pressione prolungata, tali garanzie sono state progressivamente aggirate.”

Ha esortato le organizzazioni a sottoporre i propri sistemi a simili test “sostenuti”, anche da parte di soggetti esterni.

E ha chiesto che ulteriori ricerche sulla questione siano urgenti.

NON PERDERE MAI UNA STORIA: Ricevi prima le ultime notizie e le storie esclusive seguendoci su tutte le piattaforme.